Problemstellung

Nicht nur das Zukunftsthema der automatisierten Mobilität erfordert eine robuste Umgebungswahrnehmung. Hierzu kommen unter anderem kamerabasierte Systeme zum Einsatz. Eine zentrale und sicherheitskritische Herausforderung ist dabei die zuverlässige Wahrnehmung von Personen und anderen Verkehrsteilnehmern, wie beispielsweise Fahrzeugen oder Fahrradfahrern, unabhängig von den vorherrschenden Sicht- und Lichtbedingungen. Um hierbei die Anfälligkeit von Detektionsfehlern zu verringern, können komplementäre Bildinformationen aus den Bereichen des sichtbaren Lichts sowie dem nahen Infrarotspektrum (NIR) fusioniert werden. Während bei guten Sichtbedingungen eine konventionelle Kamera ihr volles Potential für die Detektion entfaltet, kann eine Infrarotkamera die Robustheit bei schwierigen Sichtbedingungen, insbesondere bei Dunkelheit, im Nebel oder bei Regen deutlich verbessern.

Ziel

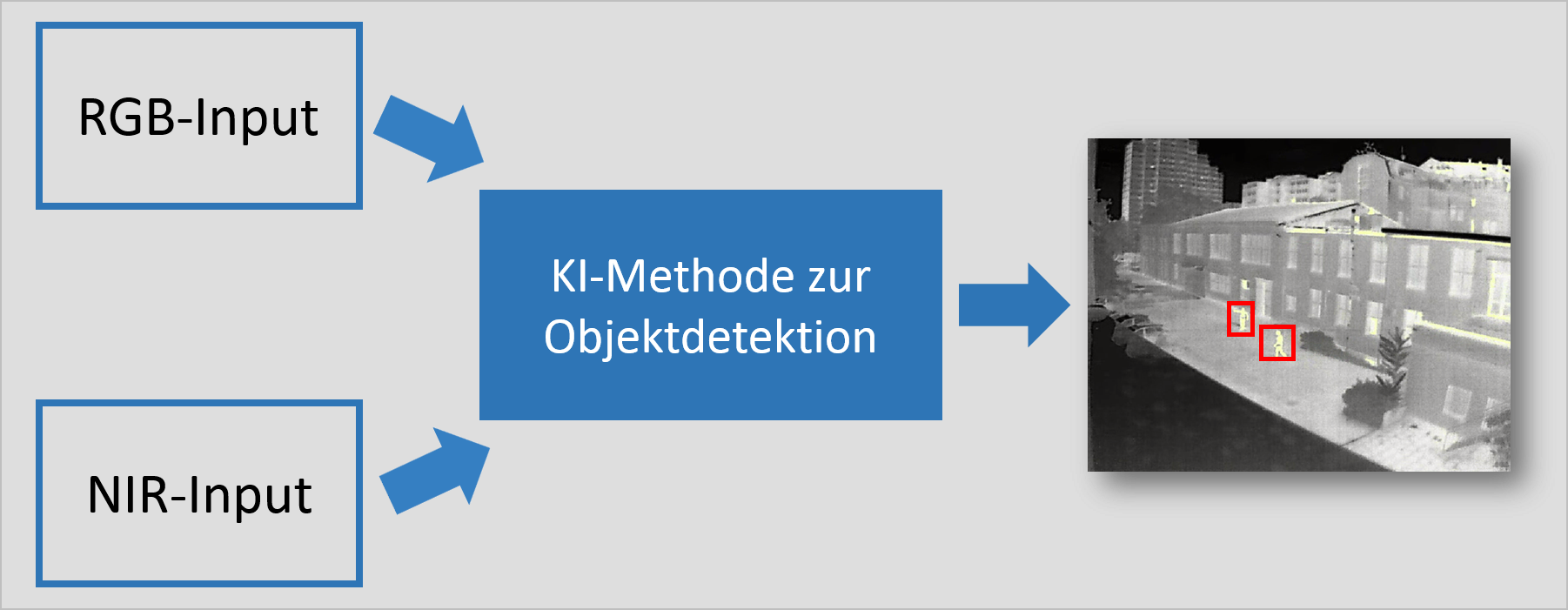

Entwicklung einer Deep Learning basierten KI-Methode, welche die komplementären Sensorinformationen aus dem Bereich des sichtbaren Lichts und dem nahen Infrarot-Spektrum fusioniert und Verkehrsteilnehmer detektiert.

Lösungskompetenz

Zunächst soll eine geeignete Deep Learning Architektur für die statische Fusion von Bilddaten ausgewählt werden. Das Training der KI-Methode erfolgt auf öffentlich verfügbaren Datensätzen als „Vortraining” und kann anschließend mit einem in der Zielapplikation aufgenommenen Datensatz für den entsprechenden Anwendungsfall angepasst und daraufhin optimiert werden.

Erprobungsumgebung

Die Erprobung der entwickelten KI-Methode kann im Rahmen des Testfeld Autonomes Fahren Baden Württemberg (TAF) aus Großinfrastrukturperspektive, oder mit Hilfe des automatisierten Versuchsfahrzeugs CoCaraus dem Fuhrpark des FZI erfolgen.

CC-KING - Kompetenzzentrum für KI-Engineering

CC-KING - Kompetenzzentrum für KI-Engineering