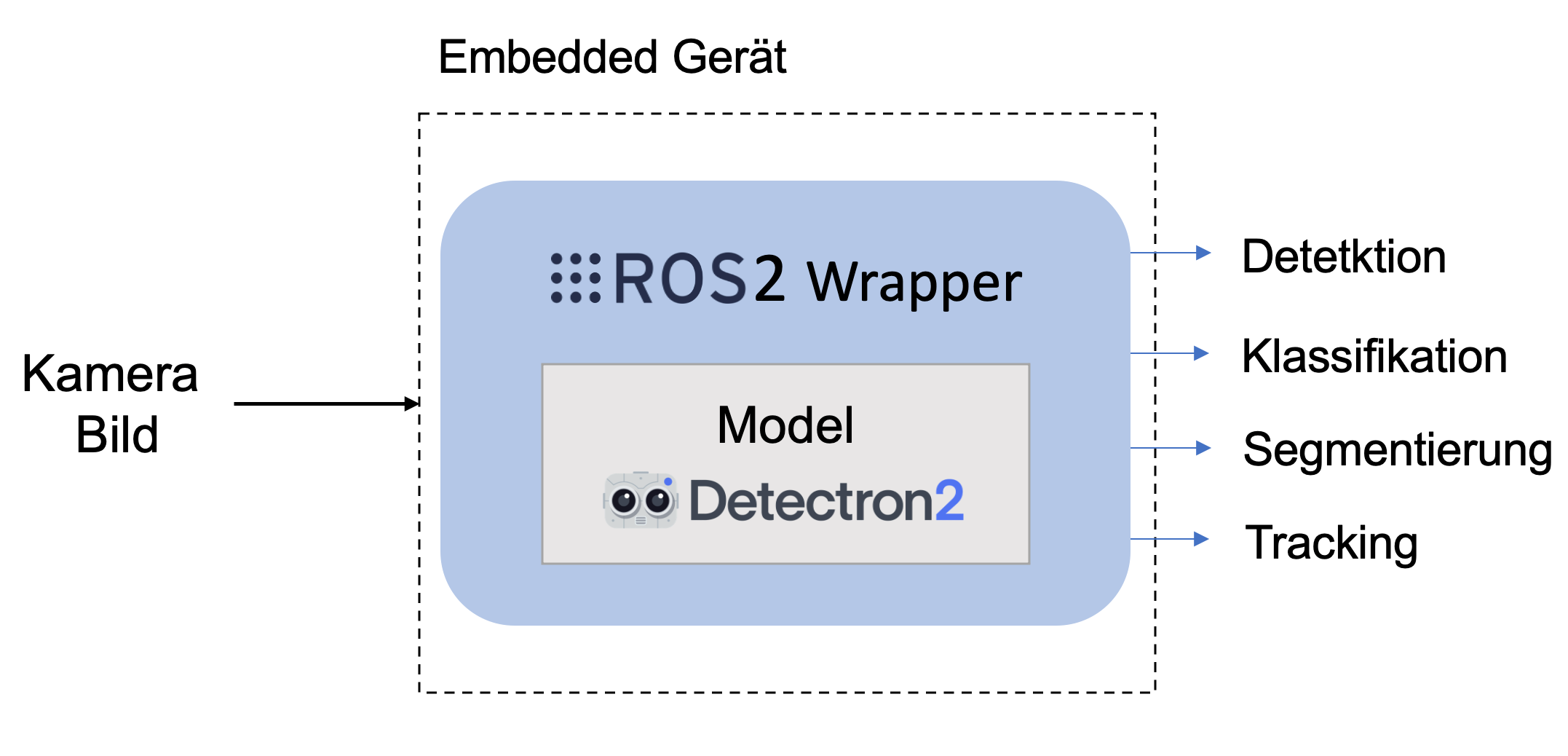

Die KI-Box wurde als eingebettetes Gerät entwickelt, das vollständig modular ist und leicht in verschiedene Systeme, wie mobile Roboterplattformen und Produktionslinien, integriert werden kann, mit dem Ziel einer effizienten und präzisen Objekterkennung & Segmentierung sowie Personenverfolgung. Diese Funktionen wurden durch die Integration von Open-Source-Softwareeinheiten und Frameworks wie Robot Operating System 2 (ROS2) und Detectron2 ermöglicht. Das entstandene Framework zur Entwicklung als auch Laufzeitumgebung bietet somit die Grundlage für die schnelle Entwicklung von Prototypen zur KI-basierten, eingebetteten Objekterkennung und Segmentierung.

ROS2 ist ein in der Robotik weitverbreitetes Kommunikations-Framework mit einer großen Zahl an Bibliotheken. Es gewährleistet Kompatibilität und einfache Integration zwischen verschiedenen Hardware-Einheiten. Darüber hinaus bietet ROS2 Sicherheitsfunktionen mit vollständiger Verschlüsselung der Pakete, die über das Protokoll übertragen werden, sowie Echtzeitkommunikation durch die Verwendung von End-to-End-Middleware wie Data Distribution Service (DDS).

Detectron2 ist ein Open-Source KI-Framework zur Verarbeitung visueller Bilddaten und intelligenter Computer Vision. Es basiert auf den Grundlagen von MASK-RCNN und bietet gebrauchsfertige Modelle, die auf vortrainierten künstlichen neuronalen Netzen basieren. Es bietet die Funktionen, um Objekte mit hoher Sicherheit zu erkennen, zu klassifizieren und zu segmentieren. Darüber hinaus kann es menschliche Posen und Bewegungen mit Skelett-Tracking erkennen und verfolgen. Das Transfer-Learning ermöglicht ein effizientes Training von künstlichen neuronalen Modellen mit geringen Datenanforderungen.

In unserem Implementierungssetup, wie im Bild zu sehen, wurde ein ROS2-Wrapper entwickelt, der eine einfache und praktische Integration mit verschiedenen ROS2-kompatiblen Hardwareeinheiten wie z. B. verschiedenen Kameras ermöglicht. Zusätzlich verwaltet ROS2 den visuellen Eingangsdatenstrom für das Detectron2-Modell, sowie die verarbeiteten Ausgangsinformationen. Dieser Ansatz gewährleistet eine hohe Modularität, da die Ausgabe der KI-Box von mehreren unabhängigen Geräten im Netzwerk gelesen werden kann.

Um die trainierten neuronalen Modelle zur Objekterkennung und -segmentierung auf einem leistungsschwachen Embedded-Gerät einsetzen zu können, sieht das Framework Methoden wie Pruning, Quantisierung und Knowledge-Distillation vor.

CC-KING - Kompetenzzentrum für KI-Engineering

CC-KING - Kompetenzzentrum für KI-Engineering