Allgemein handelt es sich bei ML Pipelines um Workflows, um eine vollständige Machine Learning Aufgabe zu lösen. Solche Pipelines bestehen dann aus einzelnen Komponenten, welche jeweils für sich gekapselt eine abgeschlossene Teilaufgabe lösen. Im klassischen Sinne enthalten diese eine Quelle (z. B. Laden der Daten aus einer Datenbank), mehrere Verarbeitungsschritte (z. B. Vorverarbeitung, Trainieren, Validierung eines Modells) und letztendlich eine Senke (z. B. Dashboard zur Ergebnisdarstellung, Speichern der Ergebnisse in einer Datenbank). Das Werkzeug „ML4P-Verarbeitungspipeline“ bietet die Möglichkeit solche Pipelines mit relativ geringem Aufwand umzusetzen.

ML4P Verarbeitungspipeline

Reiternavigation

Beschreibung

Bei der ML4P-Verarbeitungspipeline handelt es sich um einen gerichteten Graphen, der aus voneinander entkoppelten ML4P-Softwarekomponenten besteht. Die ML4P-Komponenten setzen dabei zumeist auf offener und frei verfügbarer Software auf. Neben den internen ML4P-Komponenten für die Verarbeitung von Datenströmen (z. B. via Apache Kafka), die persistente Speicherung (z. B. in einer Zeitreihendatenbank) oder das Monitoring, können bereits vorhandene Tools über ML4P-Konnektoren an die ML-Pipeline angebunden werden. So kann die Datenerfassung von Maschinen und Anlagen bspw. über einen ML4P-Konnektor zu Industrie 4.0-Verwaltungsschale und OPC Unified Architecture (OPC UA) erfolgen.

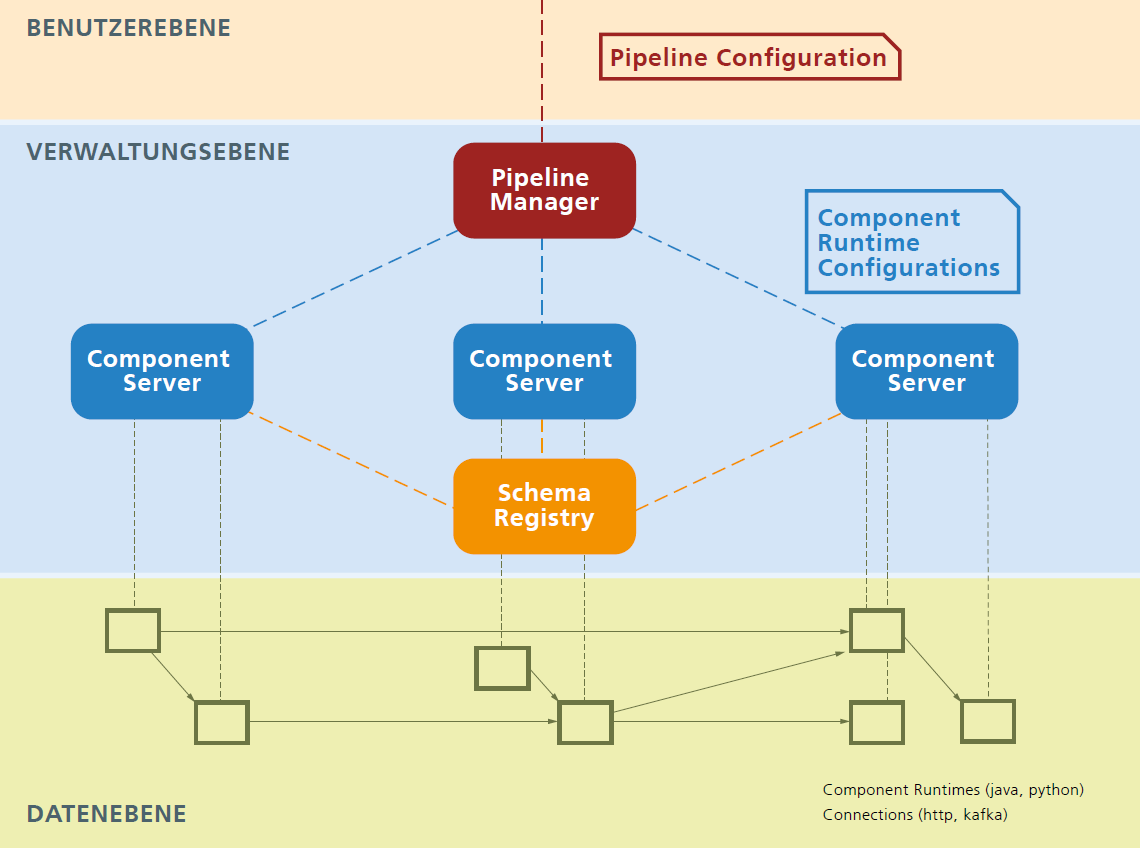

Die IT-Architektur ist in Abbildung 1 dargestellt. Der*die Benutzer*in konfiguriert die gewünschte ML-Pipeline, die anschließend von der Komponente „Pipeline Manager“ geladen werden kann. Der „Pipeline Manager“ überprüft die Korrektheit der ML-Pipeline-Konfiguration und sucht nach den in der Konfiguration vorhandenen ML4P-Komponenten in ihm bekannten „Component Server“.

In der „Registry“ werden unter anderem Schemata für den Datenaustausch zwischen ML4P-Komponenten zur Verfügung gestellt. Über diese wird sichergestellt, dass unterschiedliche ML4P-Komponenten ausgetauschte Daten stets korrekt interpretieren

Auf der „Datenebene“ sind die in der ML-Pipeline-Konfiguration enthaltenen und über spezifizierte Schnittstellen miteinander verknüpften ML4P-Komponenten dargestellt. Die Verbindung zwischen ML4P-Komponenten verwendet je nach Konfiguration Apache Kafka oder https/ReST.

Grundbausteine sind Komponenten, die jeweils spezifische Funktionalität bereitstellen und die über Ports genannte Schnittstellen miteinander kommunizieren. Ports sind typisiert, d. h. Daten, die geschrieben oder gelesen werden, müssen den Anforderungen eines spezifizierten Datenschemas genügen.

Eine ML4P Anwendung besteht aus einem Netzwerk solcher Komponenten in einer Pipeline. Pipelines werden durch einen Supervisor gestartet, überwacht und angehalten. Pipelines werden in Form einer Spezifikation definiert.

Diese Struktur erlaubt ein Höchstmaß an Flexibilität. Komponenten können in verschiedenen Programmiersprachen geschrieben werden und auf verschiedenen Plattformen laufen und der Transport von Daten kann über verschiedene Transportkanäle erfolgen.

Anwendung

Im folgenden Anwendungsfall liefert die ML4P Verarbeitungspipeline die letztendliche Implementierung des ML-Workflows am Beispiel eines am Fraunhofer IWU etablierten Presshärteprozesses. In diesem Prozess werden serienfertigungsnah B-Säulenfüße gefertigt. Dafür werden Blechrohlinge auf Temperaturen von ca. 900° C erhitzt und danach in einer Presse gleichzeitig umgeformt und abgekühlt, um sehr hohe Härten in den Bauteilen und somit Zielvorgaben der Automobilindustrie zu erfüllen.

Die Besonderheit dieses Anwendungsbeispiels liegt darin, dass sich der Presshärtevorgang als Prozesskette bestehend aus den drei Prozessschritten Erwärmen, Handling und Pressen darstellt. Als im Prozess beeinflussbare Parameter wurden Ofentemperatur, Handlingzeit, Presskraft und Presszeit identifiziert. Bisher werden einstellbare Prozessparameter durch den Anlagenbediener in Voruntersuchungen erprobt. Ziel ist es jedoch, dynamisch auf Veränderungen im Prozess reagieren zu können. Diese Anpassungen der Prozessparameter können durch die Kombination von maschinellen Lernverfahren und Optimierungsmethoden berechnet werden. In der ersten Phase wurde zur besseren Visualisierung der angestrebten Ziele ein Pipeline-Diagramm erstellt, welches als Grundlage für die ML4P-Verarbeitungspipeline verwendet wurde. Mittels der Pipeline wird während der Laufzeit die finale Bauteilqualität nach Erwärmen und nach dem Handling des Bauteils prognostiziert. Das Optimierungsverfahren errechnet letztendlich aus den prognostizierten Qualitäten die optimalen Handlingzeiten bzw. optimalen Pressenparameter.

CC-KING - Kompetenzzentrum für KI-Engineering

CC-KING - Kompetenzzentrum für KI-Engineering