Datenbereitstellung

Reiternavigation

Beschreibung

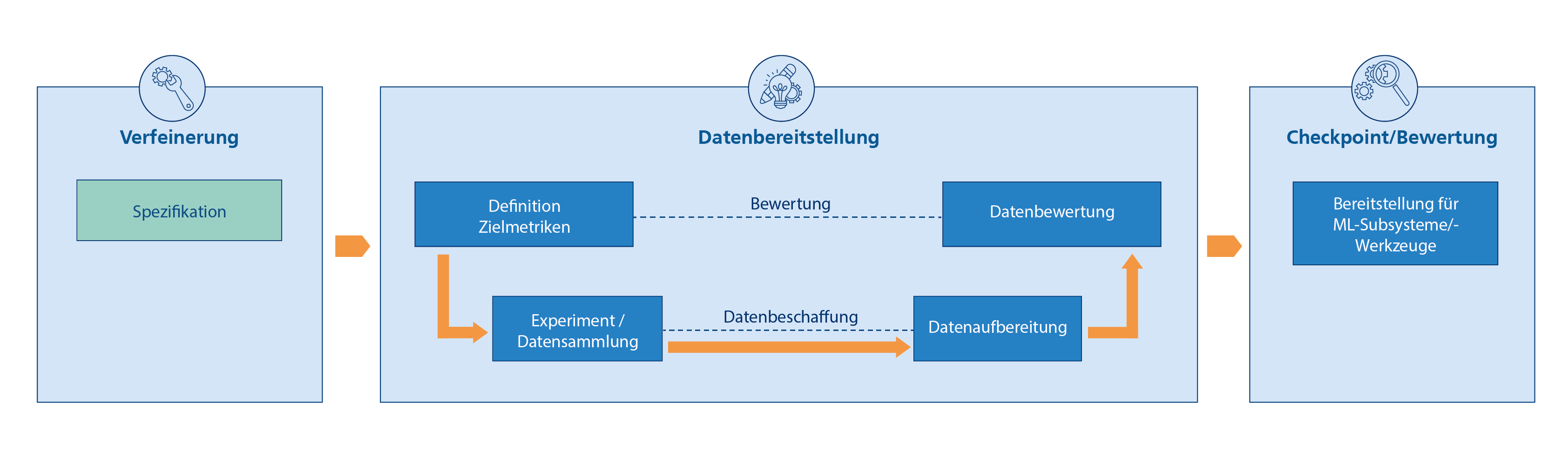

Das Vorgehen der Datenbereitstellung hat zum Ziel, Trainings-, Test- und Validierungsdatensätze zu erzeugen, aufzubereiten und zu bewerten. Dabei sollen Forderungen bezüglich der Relevanz, Repräsentativität und Fehlerfreiheit der Daten erfüllt werden. Die Daten bilden die Grundlage für die Entwicklung und Funktionalität von KI-Komponenten.

Im Schritt der Verfeinerung wird die Spezifikation der Daten angepasst. Dazu zählen sowohl Datenquellen, die für Training, Test und Laufzeit unterschiedlich sein können, als auch Anforderungen an die Daten selbst.

Die Anforderungen können technische Aspekte umfassen, die für die Erfüllung der gesetzten Aufgaben der KI-Komponente relevant sind, wie etwa die Menge an Daten, die Qualität, also ob fehlende oder falsche Angaben vorhanden sind, und die Repräsentativität, also ob die Trainingsdaten auch die Daten, die zur Laufzeit anfallen, repräsentieren können. Zusätzlich gibt es übergeordnete nicht-technische Aspekte wie Verzerrungen in der Verteilung der Daten (bias), die zu unfairen Entscheidungen führen können (z. B. geschlechterspezifische Entscheidungen bei der Personalauswahl), Kosten bei der Datenbeschaffung oder rechtliche Aspekte von personengebundenen Daten, die wiederum zusätzliche Schritte, wie Anonymisierung oder Pseudonymisierung nötig machen können.

Das anschließende Vorgehen zur Datenbereitstellung orientiert sich am V-Modell. Auf einer übergeordneten Ebene werden in einem ersten Schritt die Zielmetriken definiert, anhand derer die Daten später bewertet werden sollen. Die Zielmetriken werden hierbei von den oben genannten Anforderungen abgeleitet.

Danach folgt das Experiment bzw. die Datensammlung. Unter dem Begriff „Experiment“ ist hier eine Datensammlung unter kontrollierten Bedingungen zu verstehen. Beispielsweise kann für eine Anomalieerkennung das Sammeln von Daten – mit Repräsentanten bekannter Anomalien und des Normalzustands – durch geführte Experimente erfolgen. Im Fall von überwachtem Lernen erleichtert dies das Labeling, also das Zuordnen von Zielwerten, die von einem ML-basierten Algorithmus vorhergesagt werden sollen. In den Schritt der Datensammlung fällt zusätzlich das Aufnehmen von Daten unter realen Einsatzbedingungen und die Sammlung von künstlich erzeugten Daten, z. B. aus Simulationen, oder die Vermehrung eines schon vorhandenen Datensatzes durch Techniken der Data Augmentation. Ebenso kann in dieser Phase eine Auswahl von öffentliche Datensätzen in Betracht gezogen werden.

Die akquirierten Rohdaten werden in der Datenaufbereitung bezüglich der Problemstellung gesichtet und vorbereitet. Basierend auf der Spezifikation werden z.B. Features, also Eingabemerkmale, abgeleitet. Diese Features bilden die Grundlage für die korrekte Funktionalität der ML-Komponente. Die Auswahl der Features stützt sich vorrangig auf Domänen- bzw. Expertenwissen, aber auch Signifikanzbetrachtungen können hier maßgeblich sein.

Zusätzlich können Techniken der Aggregation mehrerer Datenpunkte, der Rauschentfernung oder aber das Filtern von unvollständigen Datenpunkten in diesem Schritt zum Einsatz kommen. Eine weitere hilfreiche Methode ist die der Data Imputation, also das Schätzen von fehlenden Werten. So können z. B. bei einem kurzzeitigen Ausfall eines Sensors das entsprechende Feature und die unvollständigen Datenpunkte trotzdem genutzt werden. Des Weiteren lassen sich mehrere Features zu einem neuen Feature kombinieren, um die Dimension und damit die Komplexität der Datenpunkte zu reduzieren.

Im Falle des überwachten Lernens im Zusammenhang mit einer Klassifikation werden in diesem Schritt, falls nicht schon automatisch bei der Aufnahme der Daten geschehen, die Daten annotiert, d.h. die Datenpunkte werden ihren jeweiligen Klassen zugeordnet. Im Rahmen der Entwicklung können der KI-Komponente auch Informationen bezüglich des Zusammenhangs zwischen Datenpunkt und Klasse mitgegeben werden. Je nach Anforderung werden in diesem Schritt auch Techniken der Anonymisierung oder Pseudonymisierung von Daten angewandt. Während manche der Aufbereitungsschritte nur für Trainings-, Test-, und Validierungsdaten nötig sind (z. B. die Annotation), müssen einige Methoden aus Gründen der Konsistenz auch auf die Daten zur Laufzeit angewendet werden (z. B. Rauschentfernung, Data Imputation, Kombination von mehreren Features etc.).

Das Vorgehen der Datenbereitstellung wird mit dem Schritt der Datenbewertung abgeschlossen. Hier kommen die vorher definierten Zielmetriken bezüglich der Anforderungen an die Daten zum Einsatz. Der Datenbewertung kommt, neben dem technischen Aspekt, auch unter rechtlichen Aspekten eine wichtige Funktion zu wenn Nachweise gegenüber externen Organisationen erbracht werden müssen. Dazu sollen laut EU-Vorschlag geeignete Governance- und Datenverwaltungsverfahren genutzt werden.

Die aufbereiteten und bewerteten Daten werden nach erfolgreichem Abschluss des Schrittes für die Entwicklung von KIKomponenten bereitgestellt.

Es sei hervorgehoben, dass der Prozess der Datenaufbereitung nicht zwangsläufig händisch ablaufen muss. Gerade hier gibt es ein großes Potenzial für die Automatisierung von einzelnen Arbeitsschritten oder Schrittfolgen.

← Zurück zum Entwicklungszyklus

Tablesort – Anwendungsfall Produktion

Grundlage für die Datenerfassung ist die Verbindung zwischen der Zeitreihendatenbank und des IoT-Hubs, welche im ersten Entwicklungszyklus hergestellt wurde. Daraufhin kann im zweiten Zyklus die Durchführung von Versuchen erfolgen, um eine Datenbasis für das zu ent-wickelnde ML-Subsystem zu erstellen.

Zur Strukturierung der Daten wird ein Datenmodell entwickelt, mit welchem eine direkte An-notation der Versuchsdaten (z.B. Normalverhalten, Ventile einseitig belastet) durchgeführt wird.

In der Spezifikation der Datensätze wird eine Länge des Experiments von 10 Minuten festge-legt. Die aufzunehmenden Datensätze sollen folgende Zielmetriken erfüllen: Während der Datennahme für den Trainingsdatensatz sollen weniger als 1% der Bohnen falsch sortiert werden, was einer guten Gleichverteilung der Bohnen auf dem Förderband entspricht. Für den Testdatensatz sollen etwa 5% der Bohnen falsch sortiert werden. Dies entspricht einer un-gleichmäßigen Verteilung der Bohnen. Alle Testdatensätze sollen zuverlässig als anomal er-kannt werden. Während der Datensammlung wird der TableSort unter kontrollierten Bedin-gungen gemäß der Spezifikationen und Zielmetriken betrieben. Die Daten werden im Schritt der Datenaufbereitung mit relevanten Metadaten versehen und auf Konsistenz geprüft, z.B. ob alle Düsen aktiv waren. Im letzten Schritt, der Datenbewertung, findet die Prüfung hinsicht-lich der gesetzten Zielmetriken statt. Die Datensätze stehen zum Checkpoint zusammen mit der entsprechenden Dokumentation für die Entwicklung des ML-Subsystems bereit

← Zurück zum Entwicklungszyklus

Automotive-Notbremssystem – Anwendungsfall Mobilität

Für die Subsystementwicklungen von Detektor und Entscheider sind Bilddaten der Fahrzeugkamera erforderlich, in denen vorausfahrende Fahrzeuge annotiert sind. Da diese Daten zu Projektbeginn nicht vorliegen, wird der öffentlich verfügbare Cityscapes-Datensatz genutzt, der reale Fahrzeugkamerabilder mit manuell annotierten Objekten enthält. Im Rahmen der Datenbereitstellung ist zu prüfen, inwieweit der Datensatz zur Zielanwendung kompatibel ist, also wie repräsentativ er ist (etwa in Bezug auf die Kameraauflösung, die Fahrszenarien, etc.). Im Folgenden beschränken wir uns beispielhaft nur auf den Aspekt der Fahrszenarien. Dafür werden im ersten Schritt Zielmetriken für die Verkehrssituation im Cityscapes-Datensatz festgelegt. Im weiteren Schritt wird der Datensatz für die Auswertung vom Anbieter heruntergeladen. In der Datenbereitstellung werden die Bilder herausgefiltert, auf denen nur Personen zu sehen sind, die zu Fuß gehen bzw. mit dem Rad fahren, da diese für den Zielanwendungsfall der Autobahnfahrt keine Bedeutung haben. Im letzten Schritt der Datenbewertung wird der gesamte Datensatz noch einmal hinsichtlich der Repräsentativität der Szenarien geprüft. Es ergibt sich, dass die Szenarien für eine vorläufige Entwicklung akzeptabel sind, jedoch zu wenige Daten aus dem Zielanwendungsfall enthalten. Cityscapes legt einen starken Fokus auf urbane Szenarien, wohingegen die Zielanwendung primär Autobahnen adressiert. Für eine erste prototypische Entwicklung des Detektors wird Cityscapes als Datenquelle für ausreichend befunden; später im Projekt sollen jedoch mittels einesHilfssystems, einer Fahrzeugsimulation, Bilder künstlich erzeugt und anschließend mit KI-Verfahren nachprozessiert werden, um sie realistischer zu machen. Schließlich sollen, sobald verfügbar, mit dem realen Ziel-Kamerasystem Messdaten im öffentlichen Verkehr erhoben und manuell annotiert werden. Dabei kommen zu den Fragen der Repräsentativität und der Datenqualität Fragen des Datenschutzes hinzu.

← Zurück zum Entwicklungszyklus

CC-KING - Kompetenzzentrum für KI-Engineering

CC-KING - Kompetenzzentrum für KI-Engineering